Google está trabajando en un sistema que permita detectar en tiempo real el lenguaje de señas en las videollamadas. El objetivo consiste en facilitar la comunicación de las personas con discapacidad auditiva, para que puedan entender en el momento lo que se está diciendo.

El proyecto haría que estas herramientas de comunicación, tan usadas hoy en día por la pandemia de la COVID-19, fueran más accesibles para este tipo de personas. Cabe destacar que no todos los que tienen discapacidad auditiva usan el lenguaje de señas. Google informó que el modelo lleva por nombre “Detección del lenguaje de señas en tiempo real mediante la estimación de pose de la persona”.

Un paso adelante

Dicho modelo se basa, entre otros aspectos, en la identificación automática de la persona que está usando el lenguaje de señas en pantalla, en la comprensión de su empleo en el momento y en el procesamiento de los movimientos de las partes del cuerpo para poderlos «traducir» al lenguaje de señas.

De este modo, un equipo presentó primero el modelo en el evento Reconocimiento del Lenguaje de Señas, Interpretación y Realización 2020 (SLRTP, por sus siglas en inglés), el cual reúne a investigadores que trabajan en diferentes aspectos relacionados con el lenguaje de señas. Después demostró su funcionamiento en la Conferencia Europea de la Visión Computacional (ECCV, por sus siglas en inglés). Ambos eventos se hicieron este año.

“Presentamos un modelo de detección de lenguaje de señas en tiempo real y demostramos cómo se puede usar para dar a los sistemas de videoconferencia un mecanismo a fin de que se pueda identificar, como un ‘orador activo’, a la persona que usa las señas”, explicó la empresa.

Liviano y fácil de usar

Con el objetivo de conseguir una solución —en tiempo real— para una variedad de aplicaciones de videoconferencia, necesitaban un modelo que fuese liviano, fácil de conectar y de usar. En concreto, ameritaban un modelo que consumiera menos ciclos de CPU, de manera que se disminuyera el efecto en la calidad de la llamada.

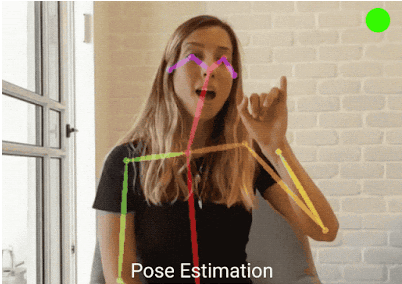

Por otro lado, y en vista de que el lenguaje de señas comprende el cuerpo y las manos de la persona, comenzaron haciendo un modelo de estimación de pose, que se denomina PoseNet. El mecanismo reduce la imagen a un pequeño grupo de puntos de referencia en el cuerpo de la persona que usa el lenguaje de señas, incluyendo los ojos, la nariz, los hombros, las manos, etc. De este modo, procesa y muestra los movimientos automáticamente.

Para poder saber cómo las personas que usan el lenguaje de señas percibían el modelo, le pidieron a un grupo que participara en un estudio de experiencia del usuario. Para ello, usaron una demostración experimental durante una videoconferencia y les dijeron que emplearan el lenguaje de señas tal como lo hacían siempre.

Entre otras cosas, los participantes dijeron que sí se veía el lenguaje de señas. También, que se mostró a la persona que lo emplea en el momento que lo hace y que se activó el icono del medidor de audio de sistema de conferencias para indicar quién está usando el lenguaje de señas.

En la esquina superior izquierda se puede ver el icono encendido del medidor de audio del sistema de conferencias que muestra, como un indicador, cuando la persona está usando el lenguaje de señas. Foto: Google

Accesibilidad y tecnología

La pandemia y, en consecuencia, el distanciamiento social y el uso de mascarillas, han dificultado más la comunicación para las personas con discapacidad auditiva.

Uno de los inconvenientes tiene que ver con que no pueden leer los labios si el interlocutor tiene la mascarilla puesta. Otra es que hay videollamadas o videoconferencias que carecen de subtítulos para poderlos leer. También carecen de intérpretes de lenguaje de señas o las intervenciones no se pueden seguir en tiempo real. Por tanto, la persona no puede saber a ciencia cierta qué se está diciendo o qué se le pregunta, por lo que se desorienta.

Aún así, hay aplicaciones con métodos de reconocimiento de voz que ayudan a entender cuando otra persona está hablando, pues transcriben los textos. Unas son más exactas que otras en las transcripciones. Solo hay que probar para ver cuál es mejor. Estas son algunas de ellas:

Lea también: